2024年4月,前OpenAI超级对齐部门成员、利奥波德·阿申布伦纳(Leopold Aschenbrenner)被OpenAI以泄露公司机密为由解雇。6月初,阿申布伦纳在网站上发布了一份长达165页的PDF文件,文件汇总了他在OpenAI工作期间所了解的信息,深入探讨了当前AI技术的进展、从人工通用智能(AGI)到超级智能(Superintelligence)的发展路径等问题。

图片来源:X

6月初,利奥波德·阿申布伦纳在博客节目Dwarkesh Podcast中,透露他被开除的真实原因——他给几位董事会成员分享了一份OpenAI安全备忘录,结果导致OpenAI管理层不满。同日,阿申布伦纳在社交平台上,发布了一份长达165页的PDF文档。

图片来源:X

阿申布伦纳将他的这份文件命名为《态势感知》(Situational Awareness)。在文件的开头,他特别指出,虽然自己曾在OpenAI工作,但自己的预测都是基于公开信息、自己的想法、工作期间的八卦等。他还在这份文件的开头特别致敬了前OpenAI首席科学家伊尔亚·苏茨克维(Ilya Sutskever)和其他OpenAI超级对齐团队的成员。

他认为目前全世界只有仅仅几百人对AI的发展有真正意义上的感知,这些人大多集中在旧金山地区以及全球各地的AI实验室里,自己便是这几百人中的一员。而那些主流评论家们只看到了炒作和常规的商业模式,他们认为这不过是另一场互联网规模的技术变革。

图片来源:《态势感知》

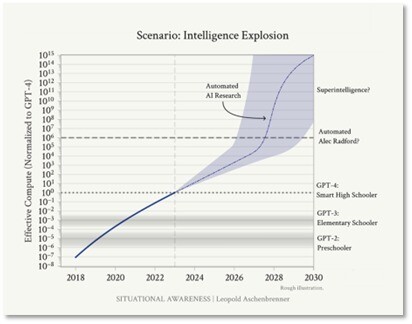

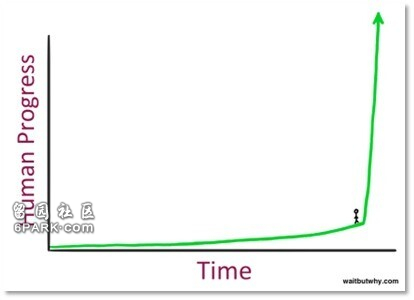

阿申布伦纳在文章中指出,AI的进步不会止步于人类水平。例如,在最初学习了人类最好的棋局之后,AlphaGo开始与自己对弈,它很快实现了超越人类的水平,下出了人类永远无法想出的极具创意和复杂性的棋步。

在实现AGI后,人类将能够利用先进的AGI系统实现自动化的AI研究,将十年的算法进步压缩到一年内。这意味着我们将迅速从人类水平的AI系统过渡到远超人类的超级智能系统。这可能会将人类10年的算法进展压缩到不到1年的时间里。与现有领先的AI实验室的数百名研究人员和工程师相比,未来的AI实验室可能会拥有成千上万个AGI系统,夜以继日地努力实现算法突破,不断自我完善,加速算法进步的现有趋势。

图片来源:《态势感知》

他写道:“超级智能的力量和危险将是戏剧性的。”这种转变不仅会带来技术上的飞跃,还将引发一系列伦理和安全问题。

阿申布伦纳强调,通过一些新的创新,超级智能在几周内就能获得相当于人类数十亿年的经验。这种前所未有的学习速度将使超级智能在数量和质量上远超人类。他指出:“这些AI系统将能够以我们无法想象的速度进行思考和学习。”

阿申布伦纳预测,到本世纪末,我们将拥有数以亿计的超级智能,这些智能体将在数量和质量上远超人类。他写道:“在数以亿计的GPU上运行的超级智能,将能够比人类快几个数量级地‘思考’。”这种超级智能的涌现将带来巨大的技术进步,但也伴随着巨大的风险。

图片来源:《态势感知》

文章中最引人注目的观点之一是,十亿超级智能将能够将人类研究人员在下个世纪进行的研发工作压缩到几年内。这种压缩效应将极大地加速技术进步,但也可能带来难以预见的后果。

阿申布伦纳指出:“超级智能将是人类有史以来最强大的技术——也是最强大的武器。它将赋予军事上决定性的优势,或许只有核武器可以相比。”

阿申布伦纳强调,智能爆炸和其直接后果将带来人类历史上最为动荡和紧张的局面。他指出:“在这个初期阶段,人类的任务将不是制造酷炫的产品,而是要尽一切可能度过这一时期。”他呼吁建立一个能够严肃对待这些困难抉择的指挥链,以稳定国际局势并管理智能爆炸期间的风险。

他进一步提到,尽管对齐技术可能会被滥用,但我们仍需要更好的对齐技术来确保未来模型的基本限制,如遵循指令或遵守法律。这些技术不仅仅是为了防止滥用,更是为了确保AI能够在安全的框架内运行。

展望未来,阿申布伦纳认为,我们正处于一个前所未有的快速发展时期,预计在未来四年内,计算能力将再提升约10万倍,带来类似于GPT-2到GPT-4的质的飞跃。他指出,这不仅意味着更好的聊天机器人,更意味着从工具到代理的转变,从一个简单的工具到一个更像是远程助手的存在。