也许你还记得,在去年六月,有一群中国人利用特效换脸,开始假装俄罗斯人带货。

从室内到户外,从城市到农村,他们活跃在在每片能支棱起手机拍视频开直播的土地上,操着一口带有浓郁方言味的普通话,在商品橱窗里上链接。

他们的视频和直播里,没有什么狠活。

总结起来就一句话, “ 我,俄罗斯人,喜欢中国,打钱 ” 。

我本以为,随着那篇报道的结束,中国人假冒毛子的故事就告一段落。

但我万万没想到,在 2024 年,这个套路他 360 度大升级了。

具体是咋回事呢?

这两天,一个叫 Olga Loiek 的乌克兰女孩发了条视频,说有个朋友给她发个链接,自己一看,人都傻了。

好家伙,我怎么在中国咔咔带上货了??

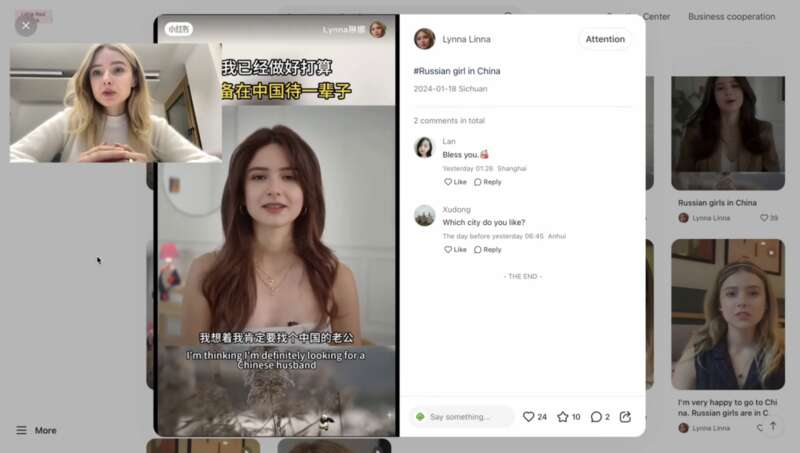

原来在小红书上,有这样一类账号,天天就是一个长相完全一致的金发美女,变着法的讲中俄友谊长存,三句离不开谢谢中国。视频结尾,还会给你介绍下俄罗斯的美食。

而看视频的老铁们,自然也要照顾下大妹子的生意。

是的,成百上千万中国观众看到的这张侃侃而谈的 “ 脸庞 ” ,就是 Olga Loiek 。

反观 Olga ,自己还没在 YouTube 上赚到半毛钱呢。

而且更尴尬的是,脸被别人偷去用来带货不说,作为一个乌克兰人,人设还是个俄罗斯人,带得还都是人俄罗斯的土特产。。。这找谁说理去。

如果你没法和这个女孩共情,不妨可以设想一下,一个美国人顶着你的脸,假装自己是日本人,变着法吹日本。

然后他还利用你的脸,从其他美国人手里,赚了你这辈子都不一定能赚到的钱,在视频评论区里,观众们刷的都是 “ 你好日本,爱来自美国 ” 。

你气不气?

Olga Loiek 也不是唯一一个倒霉蛋,另一位来自瑞典的网红拉纳布莱克利的脸,也被移花接木到了中国人脸上。

在视频里, “ 她 ” 大谈中国人的勤劳善良,并且嫁给中国老公,余生在中国定居。

看完视频的网友也不知道自己成了即将被噶的韭菜,还在问她喜欢中国哪个城市。

在抽查了几个被 Olga Loiek 展示的账号之后,我发现这些假冒外国人的中国账号,有些已经在各大平台注销掉了,但还有一些依旧逍遥法外。

可世上只有千日做贼,哪有千日防贼。

AI 技术的发展速度,明显比人类目前的应对速度要快。

在一年前, AI 技术还是被网友嘲笑的对象,网友看了也只会觉得这辈子的恐怖谷效应都犯完了。

然而现在, AI 技术已经可以产生以假乱真的效果了。

变化总是在悄无声息中进行,在 AI 技术日渐进步的今天,眼睛和耳朵,正在逐渐失去辨别能力。

人的知觉,正在信息时代的冲击下 “ 被退化 ” 。

看到这,估计很多差友会觉得这些事都离自己太远,比如那个假冒的乌克兰女孩,懂行的一看就知道了,完全骗不到自己啊?

那你再试试这个呢?

如果你比较关注游戏杂谈,那你可能还记得一个叫做敖厂长的视频博主,他因为几波舆论潮,基本败完了自己的口碑。

在去年,他先后停止了 B 站和抖音的更新,悄无声息的从网友的关注列表里消失了。

可就在前两天,一位 B 站 UP 主用自研 AI 文本转语音技术,搭配上他原有的文案和剪辑风格,愣是复刻了一整个 UP 主敖厂长出来,给我看恍惚了。

弹幕里都在刷 “ 亡灵法师 ”“ 招魂成功 ” 。

在这个 UP 主页贴出的网址中,还能找到更多奇奇怪怪的 AI 音声,比如丁真、科比、孙笑川,以及一些知道这个网站八成要发律师函的明星们。

那么,使用 AI 生成一个人的音声,要搜集多少真人的声音呢?

UP 主在视频介绍中,给出的答案是:5 秒。

没错,你只要说 5 秒钟的话,你的声音就可能已经被克隆了。

如果以上的技术,能够用在发展生产力,推动社会进步上,那勉强还能算是最好的结局。

但你要知道,现在的 AI 技术,已经越来越下沉。

第一天出了个厉害的 AI 软件,第二天使用教程就有博主给你发抖音了,简直就是手把手教学,从入坑到精通给你安排的明明白白。

不可否认,这是一件好事,可它也把人心底的阴暗面一点点放大,最后形成公共事件。

前几天, AI 生成的泰勒斯威夫特虚假不雅照片,在整个网络上疯传,甚至惊动了美国白宫。

白宫新闻发言人卡里娜 · 让 - 皮埃尔警告 AI 生成照片的传播 “ 令人担忧 ” ,并敦促社交媒体公司防止此类错误信息的传播。

泰勒这事为啥这么爆炸?毕竟早在 PS 时代,就有很多女性饱受换脸的困扰了对吧?

但在 AI 时代,照片里的所有细节都可以被精心定制。

泰勒这次,就是因为交了一个橄榄球星男朋友,被生成出了在橄榄球更衣室里的照片。。。

换谁不急眼?

后来也是由于类似的图片过多,推特一度封锁了对斯威夫特的相关搜索。

为什么全美国因为这事都开始变得神经兮兮,因为大家都清楚,今天是泰勒,明天可能就是自己。

而且 AI 干的坏事,也不只是下三路,它的能量比你想的庞大。

在中国香港,发生过一起 AI“ 深度伪造 ” 诈骗案。

诈骗者就是通过 AI 技术,把网上搜集到的跨国公司总部高层的声音和面貌,替换到自己身上,然后,简简单单从该公司的香港分公司骗走了 2 亿港元,甚至,公司财务连老板的人脸和声音都没看出来有啥异常。

你以为 AI 也就到这种程度吗?

别忘了, 2022 年,乌克兰总统泽连斯基 “ 呼吁乌克兰士兵放下武器投降 ” 的视频在网上传播。

这条十分整蛊的视频,逼到乌克兰国防部都要站出来声明 “ 这是不可能的 ” 。

由此可见,从个人到团体,甚至是国家之间的战争,每个能钻的空子,都成为了 AI 的突破口。

更可怕是,到目前为止,还没有一个特别好的招儿能防让住人用 AI 干坏事。

网络安全业内人士,i春秋的朋友小傲( 化名 )就告诉世超,反 AI 犯罪的难点主要有两方面,一个是技术层面,一个是经济层面。

在技术层面上, AI 生成内容的识别难度大,特别是 AI 越发展,肉眼能识别出来的概率也越小,这种时候就只能上机器。

而在经济层面上,用 AI 来犯罪并不是难事也不需要花什么钱,但用 AI 来反 AI 的成本就高了,你得砸钱出力去搞研究。

现阶段,国内外有不少监管机构和公司在想法子拴住 AI ,去年公安部就端了个用 AI 写勒索病毒的团伙。

市面上,也有不少检测 AI 生成内容的工具,但效果还不好说。

像 OpenAI 之前就推出过一款文本检测工具,但因为检测错误率太高偷偷给下架了。。。

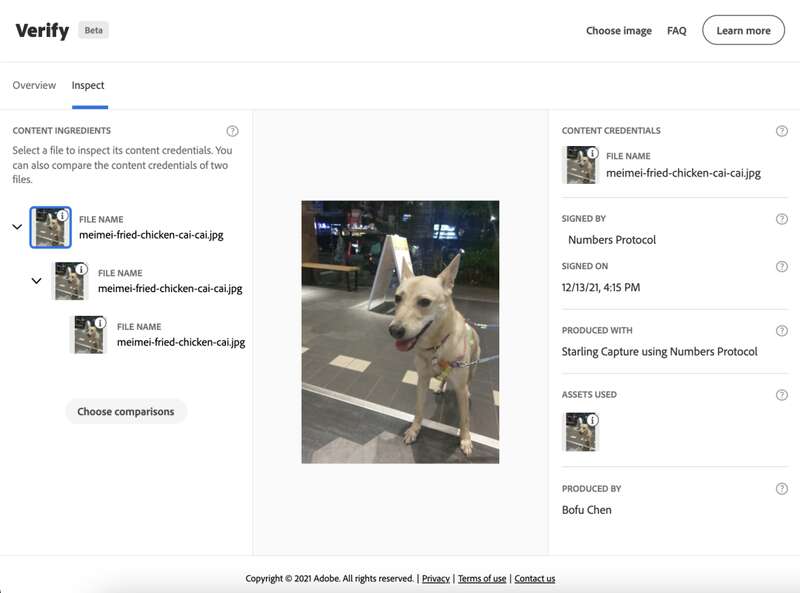

两年前,微软还有 BBC 等几家科技公司和媒体一起合作,成立了个内容来源和真实性联盟 ( C2PA ) 。

有了 C2PA 协议之后,内容是谁创作的,历史的修改记录,都会被记录下来。就相当于给生成的内容,打上了一层看不见的水印。

但用小傲的话来说, C2PA 这玩意属于防君子不防小人,大厂守规矩,不代表很多开源调出来的小模型,也会遵守协议。

而且, C2PA 现在还有不少 Bug ,像一截图水印就没了,要生效也得好几个平台都使用协议才行。

所以很残酷的一个现实是,现阶段咱们没法儿杜绝 AI 干坏事。

关键在于, AI 技术发展得实在是太快了, AI 生成的内容越来越逼真,生成的门槛却越来越低,就像 Sora 问世后,大家都在说 “ 现实,不存在了 ” 。

不可否认,之后的立法、反 AI 技术肯定会跟上,但这种敌在暗我在明的情况,监管就很被动了。

这就像一场猫鼠游戏, AI 知道规则就会绕过去,人类再设置新的规则,这场游戏,或许永无止境。

我们能做的,除了多加分辨,就只剩下下载国家反诈中心 App 了。