人工智能(AI)行业又迎来了疯狂、震撼的一夜。

北京时间2月16日凌晨2点左右,美国OpenAI公司正式发布其首个文本-视频生成模型Sora。

据悉,通过简短或详细的提示词描述,或一张静态图片,Sora就能生成类似电影的逼真场景,涵盖多个角色、不同类型动作和背景细节等,最高能生成1分钟左右的1080P高清视频。

这是继Runway、Pika、谷歌和 Meta 之后,OpenAI 正式加入到这场 AI 视频生成领域“战争”当中,同时也是GPT、DALL·E之后,2024年 OpenAI 发布的旗下最新、最重要的 AI 产品系列。

OpenAI强调,“Sora是能够理解和模拟现实世界的模型的基础,我们相信这一功能将成为实现通用人工智能(AGI)的重要里程碑。”

更早之前,谷歌昨夜23点突然升级了Gemini系列模型,并发布用于早期测试的Gemini 1.5第一个版本——Gemini 1.5 Pro,采用稀疏MOE架构,配备了128000 个 token 上下文窗口,性能和长文本都超过了GPT-4 Turbo。

从Sora到Gemini,所有人都在感叹:行业真的变天了,AI 快要把人类KO了;好莱坞的时代真的要结束了?

OpenAI视频生成模型Sora诞生:效果炸裂、现实不存在了

OpenAI今晨公布的首个视频生成模型Sora,采用一种名为扩散模型的技术(diffusion probabilistic models)。

而且,与 GPT 模型类似,Sora 也使用了Transformer 架构,并完美继承DALL·E 3的画质和遵循指令能力,生成的视频一开始看起来像静态噪音,然后通过多个步骤去除噪音,逐步转换视频。

对于初学者来说,Sora 可以生成各种风格的视频(例如,真实感、动画、黑白),最长可达一分钟 —— 比大多数文本-视频模型要长得多。

这些视频保持了合理的连贯性。相比其他 AI 视频模型,Sora视频生成质量好多了,更让人“舒服”——没有出现“人工智能怪异”类场景。

比如,AI 想象中的“龙年春节”,Sora能形成紧跟舞龙队伍抬头好奇的儿童,也能生成海量人物角色各种行为。

输入 prompt(提示词):一位 24 岁女性眨眼的极端特写,在魔法时刻站在马拉喀什,70 毫米拍摄的电影,景深,鲜艳的色彩,电影效果。

输入 prompt(提示词):一朵巨大、高耸的人形云笼罩着大地。云人向大地射出闪电。

输入 prompt(提示词):几只巨大的毛茸茸的猛犸象踏着白雪皑皑的草地走近,它们长长的毛茸茸的皮毛在风中轻轻飘动,远处覆盖着积雪的树木和雄伟的雪山,午后的阳光下有缕缕云彩,太阳高高地挂在空中距离产生温暖的光芒,低相机视角令人惊叹地捕捉到大型毛茸茸的哺乳动物,具有美丽的摄影和景深效果。

通过这些动图来看,Sora不仅可以在单个视频中创建多个镜头,而且还可以依靠对语言的深入理解准确地解释提示词,保留角色和视觉风格。

当然,Sora也存在一些弱点,OpenAI表示,它可能难以准确模拟复杂场景的物理原理;可能无法理解因果关系;还可能混淆提示的空间细节;可能难以精确描述随着时间推移发生的事件,例如遵循特定的相机轨迹等。

但瑕不掩瑜,Sora不仅能模拟真实世界,而且包括学习了摄影师和导演的表达手法,将 AI 视频惟妙惟肖地展现出来。

因此,Sora已经成为了目前最强的 AI 视频生成类模型。

在社交平台上,已经有一些视觉艺术家、设计师和电影制作人(以及OpenAI员工)获得Sora访问权限。他们开始不断放出新的提示词,OpenAI CEO奥尔特曼开始了“在线接单”模式。

带上提示词@sama,你就有可能收到奥尔特曼“亲自发布”的 AI 视频回复。

截至发稿前,OpenAI公布了更多关于Sora的技术细节。

技术报告显示,OpenAI并不是把Sora单纯当做一个视频模型来看待:将视频生成模型作为“世界模拟器”,不仅可以在不同设备的原生宽高比直接创建内容,而且展示了一些有趣的模拟能力,如3D一致性、长期一致性和对象持久性等。

“我们探索视频数据生成模型的大规模训练。具体来说,我们在可变持续时间、分辨率和宽高比的视频和图像上联合训练文本条件扩散模型。我们利用对视频和图像潜在代码的时空补丁进行操作的Transformer架构。我们最大的模型 Sora 能够生成一分钟的高保真视频。我们的结果表明,扩展视频生成模型是构建物理世界通用模拟器的一条有前途的途径。”OpenAI表示。

整体来看,Sora生成的视频噪音比较少,原始的训练数据比较“干净”,而且基于ChatGPT、DALL·E 文生图技术能力,Sora视频生成技术更加高超。

消息公布后,网友直呼,工作要丢了,视频素材行业要RIP。

论文链接:https://shrtm.nu/sqr

谷歌Gemini1.5火速上线:MoE架构,100万上下文

除了Sora之外,今天凌晨,计划全面超越GPT的谷歌,宣布推出 Gemini 1.5。

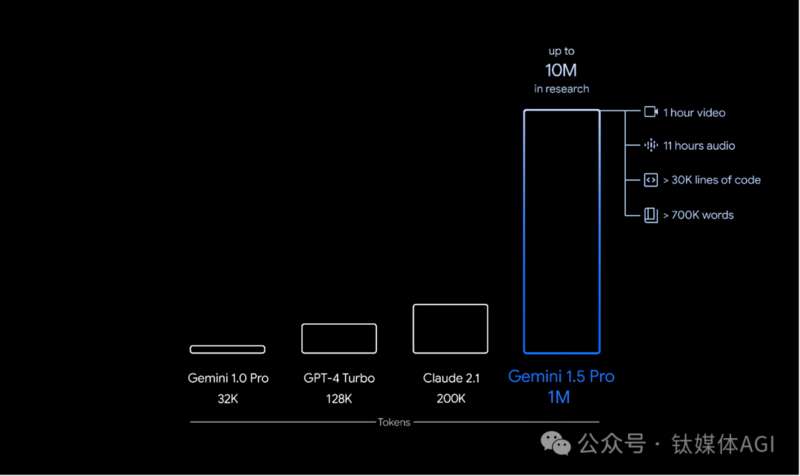

Gemini 1.5 建立在谷歌基础模型开发和基础设施之上,采用包括通过全新稀疏专家混合 (MoE) 架构,第一个版本Gemini 1.5 Pro 配备了128000个token 上下文窗口,可推理100,000 行代码,提供有用的解决方案、修改和注释使 Gemini 1.5 的训练和服务更加高效。

谷歌称,Gemini 1.5 Pro性能水平与谷歌迄今为止最大的模型 1.0 Ultra 类似,并引入了长上下文理解方面的突破性实验特征,性能、文本长度均超越了GPT-4 Turbo。

从今天开始,少数开发人员和企业客户可以通过 AI Studio 和 Vertex AI 的私人预览版在最多 100 万个 token 的上下文窗口中进行尝试 1.5 Pro 预览版。

谷歌表示,其致力于负责任地将每个新一代 Gemini 模型带给全球数十亿人、开发者和企业用户使用。未来,当模型进行更广泛的发布时,届时谷歌将推出具有标准 128,000 个 token的 1.5 Pro版本,甚至扩展到100 万个 token 的定价等级。

One More Thing:AI 行业都“卷”起来了

有趣的是,截至发稿前,Meta也公布了一种视频联合嵌入预测架构技术V-JEPA。

这是一种通过观看视频教会机器理解和模拟物理世界的方法,V-JEPA可以通过自己观看视频来学习,而不需要人类监督,也不需要对视频数据集进行标记,甚至根据一张静止图片来生成一个动态的视频。

与其他模型相比,V-JEPA的灵活性使其在训练和样本效率上实现了1.5到6倍的提升。另外,在图像分类中,它可识别图像中的主要对象或场景;动作分类方面,它识别视频片段中的特定动作或活动;时空动作检测方面,可识别视频中动作的类型及其发生的具体时间和位置。

跑分方面,V-JEPA在Kinetics-400达到了82.0%的准确率;Something-Something-v2达到了72.2%的准确率;ImageNet1K图像分类任务上达到了77.9%的准确率。

Meta称,这是人工智能模型迈出的又一重要一步利用对世界的学习理解来计划、推理和完成复杂的任务。而且,V-JEPA展示了Meta在通过视频理解推进机器智能方面的先进成就,为实现更高级的机器智能和人工通用智能(AGI)奠定基础。

总结来看,2024年开年,AI 大模型技术进展全面加速,视频、图像、文本生成能力比一年前大大增强。

如果说,2023年还是“AI 图文生成元年”的话,今年,OpenAI将推动行业进入”AI视频生成元年”。

如果按照最近估值超过800亿美元的OpenAI公布新产品的速度来计算,GPT-5将很快对外发布。

2月初,被誉为“女版巴菲特”的方舟投资管理公司CEO凯茜·伍德(Cathie Wood)最新预测,AI 技术发展速度快于市场预期,AGI最早将在2026年出现,最晚则到2030年出现

OpenAI Sora问世,通往AGI的又一个ChatGPT时刻!GPT4可能也要被干掉了

OpenAI的文生视频模型Sora刷屏了。

它有多震撼呢?这么说吧,上一次这么疯狂的刷屏可能还是人类第一次见到ChatGPT的时候。以及,Sora之前几小时Google刚刚推出了它最强的LLM Gemini1.5,并试图宣称自己终于杀死了GPT-4,然而,显然现在没人关注了。

因为看完Sora你可能会发现,OpenAI自己可能要用它先杀死GPT-4了。

每个人都可以创造自己的世界了

先来看看Sora。

人们一直期待GPT-5,但Sora带来的轰动不亚于一次GPT-5的发布。

作为OpenAI 首推的文本转视频模型,Sora能够根据文本指令或静态图像生成长达 1分钟的视频,其中包含精细复杂的场景、生动的角色表情以及复杂的镜头运动。同时也接受现有视频扩展或填补缺失的帧。

每条提示60秒的视频长度与Pika Labs的3秒、Meta Emu Video的4秒、和Runway公司Gen-2的18秒相比,妥妥地铁赢了。并且从官方发布的演示来看,无论从视频流畅度还是细节表现能力上,Sora的效果都相当惊艳。

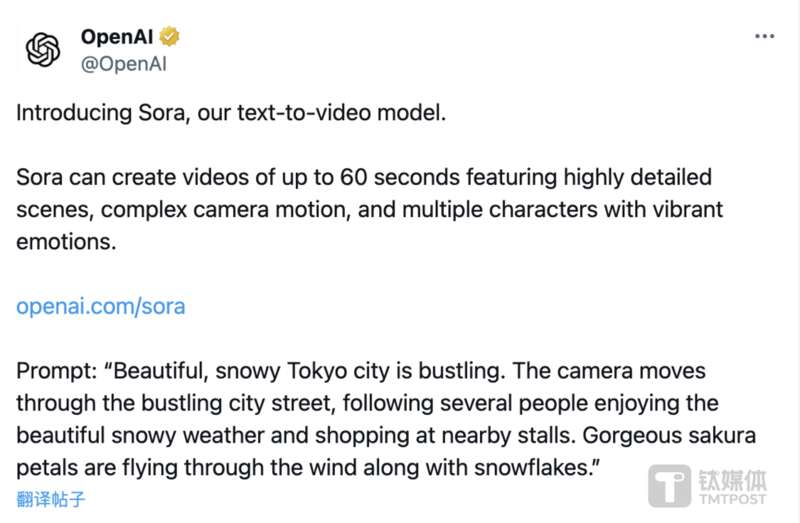

比如官推里这条14秒的东京雪景视频。

提示词:Beautiful, snowy Tokyo city is bustling. The camera moves through the bustling city street, following several people enjoying the beautiful snowy weather and shopping at nearby stalls. Gorgeous sakura petals are flying through the wind along with snowflakes.

「美丽的,被雪覆盖的东京正繁忙着。镜头穿过繁忙的城市街道,跟随着几个享受雪景和在附近摊位购物的人。美丽的樱花瓣随风飘落,与雪花一同飞舞。」

穿着时尚的女性漫步在霓虹背景的东京街头,地面有积水倒影。

对于五官和皮肤的刻画十分真实,特别是痘印和法令纹,细节让人惊叹。

猛犸象自冰川雪原中缓步从来,背后升腾起雪雾。

烛火旁纯真顽皮的3D动画小怪物,光影、表情和毛茸茸的细节满分:

一名24岁女性的眼部特写,足以以假乱真。

无人机视角的海浪拍打着Big Sur加瑞角海岸崖壁,落日洒下金色光芒。

窗台上的花朵开放延时影像:

民众们上街舞龙,庆祝中国农历春节。

可爱小猫咪在线安抚起床气。

夜晚街道跑着的快乐小狗。

两艘微型海盗船在一杯咖啡里对峙。

加州淘金时代罕见“历史影像”流出—— 像吗?Sora做的。

目前Sora还在测试阶段,仅对部分评估人员、视觉艺术家、设计师和电影制作人们开放访问权限,拿到试用资格的人们已经开始想象力横飞。

Sam Altman就转发网友用Sora制作的“金光灿灿动物园”视频,玩起了自己的“What”梗:

他还邀请大家踊跃提出想用Sora制作视频的提示词,团队马上为大家生成,瞬间8千多条回复。

网友脑洞大开,要看海洋生物的自行车公开赛。

两只金毛在山上戴着耳机开播客。

当然也不忘cue一下去向成谜的Ilya,要求生成一个“Ilya眼中的真实世界”。

不过OpenAI也表示,虽然Sora 对自然语言有着深入的理解,能够准确洞悉提示词,生成表达丰富的内容,并可以创建多个镜头、保持角色和视觉风格的一致性,但仍不可避免地存在一些弱点。

例如,它在准确模拟复杂场景的物理现象方面存在困难,也可能不理解特定的因果关系。比方说“一个人咬一口饼干后,饼干上可能并没有咬痕。”

模型也可能混淆提示的空间细节,像是弄错左右。或者“在准确体现随时间发生的事件方面遇到困难,比如遵循特定的摄像机轨迹”。

Sora也使用了DALL·E 3的recaptioning技术,该技术涉及为视觉训练数据生成高度描述性的标题。因此模型能够更忠实地按照用户在生成视频中的文本指令进行操作。

它能够一次性生成整个视频,或是扩展已生成的视频使其变长。通过让模型一次性预见多帧,解决了即使主体暂时离开视线也能保持不变的挑战性问题。

关于安全性,OpenAI表示正与错误信息、仇恨内容和偏见等领域的专家合作,对模型进行对抗性测试。同时也在开发帮助检测误导性内容的工具,识别视频是否由Sora生成。对于违反使用政策的文本提示,例如暴力、仇恨和侵犯他人知识产权等内容,将拒绝显示给用户。

除此以外,为DALL·E 3产品构建的现有安全方法也同样适用于Sora。

“尽管进行了广泛的研究和测试,我们仍无法预测人们将如何利用我们的技术,也无法预见人们如何滥用它。这就是为什么我们相信,从真实世界的用例中学习,是随时间构建越来越安全的AI系统的关键组成部分。”

OpenAI对 Sora信心满满,认为这为模型理解和模拟真实世界奠定了基础,是“实现AGI的重要里程碑”。

网友们也第n+1次纷纷哀悼起相关赛道的公司们:

“OpenAI就是不能停止杀死创业公司。”

“天哪,现在起我们要弄清什么是真的,什么是假的。”

“我的工作没了。”

“整个影像素材行业被血洗,安息吧。”

能杀死GPT-4的世界模型?这不就是吗

OpenAI一如既往没有给出很详细的技术说明,但一些只言片语已经足够让你浮想联翩。

其中最吸引我们注意的第一个点,是对数据的处理。

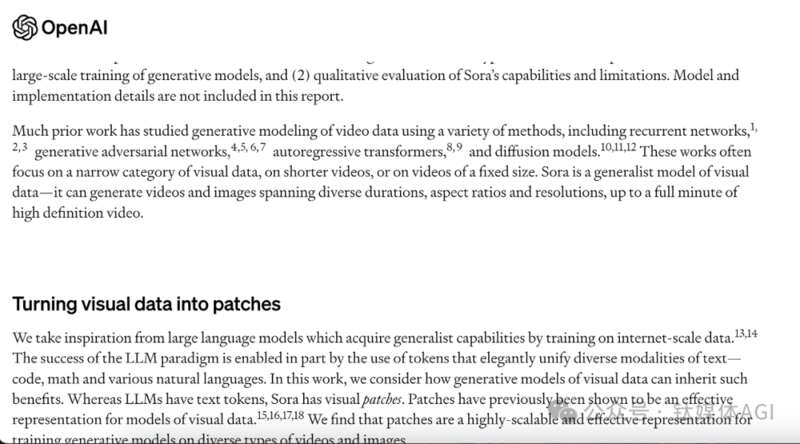

Sora是一个扩散模型(diffusion model),采用类似GPT的Transformer架构。而在解决训练中文本资料与视频数据之间的统一方面,OpenAI表示,他们在处理图像和视频数据时,把对它们进行分割后得到的最小单元,称为小块(patches),也就是对应LLM里的基本单元tokens。

这是一个很重要的技术细节。把它作为模型处理的基本单元,使得深度学习算法能够更有效地处理各种视觉数据,涵盖不同的持续时间、分辨率和宽高比。

从最终的震撼效果看,你很难不得出这样一个结论:对语言的理解能力,是可以迁移到对更多形态的数据的理解方法上去的。

此前的Dalle-3的效果就被公认很大程度来自OpenAI在GPT上积累的领先N代的语言能力,哪怕是个图像为输出的模型,语言能力提升也是至关重要的。而今天的视频模型,同样如此。

至于它是如何做到的,有不少行业内的专家给出了相同的猜测:它的训练数据里使用了游戏领域最前端的物理引擎Unreal Engine5,简单粗暴的理解,就是语言能力足够强大之后,它带来的泛化能力直接可以学习引擎生成的图像视频数据和它体现出的模式,然后还可以直接用学习来的,引擎最能理解的方式给这些利用了引擎的强大技术的视觉模型模块下指令,生成我们看到的逼真强大的对物理世界体现出“理解”的视频。

基于这个猜测,OpenAI简短的介绍中的这句话似乎就更加重要了:

“Sora 是能够理解和模拟现实世界的模型的基础,OpenAI相信这一功能将成为实现AGI的重要里程碑。”

理解,现实,世界。

这不就是人们总在争论的那个唯一有可能“干掉”GPT-4的世界模型。现在,OpenAI搞出来了它的雏形,摆在了你的面前。

看起来,这个模型学会了关于 3D 几何形状和一致性的知识,而且并非OpenAI训练团队预先设定的,而是完全是通过观察大量数据自然而然地学会的。负责Sora训练的OpenAI科学家Tim Brooks表示,AGI将能够模拟物理世界,而Sora就是迈向这个方向的关键一步。

显然,在OpenAI眼里,它不只是一个“文生视频模型”,而是更大的东西。

我们如果尝试进一步给一个暴论,就是:语言是理解一切的基础,理解了视频后,世界模型才会到来。

可能这才是比今天刷屏感慨“现实不存在了”之外,更恐怖的地方。这可能是人类通往AGI的又一个ChatGPT时刻