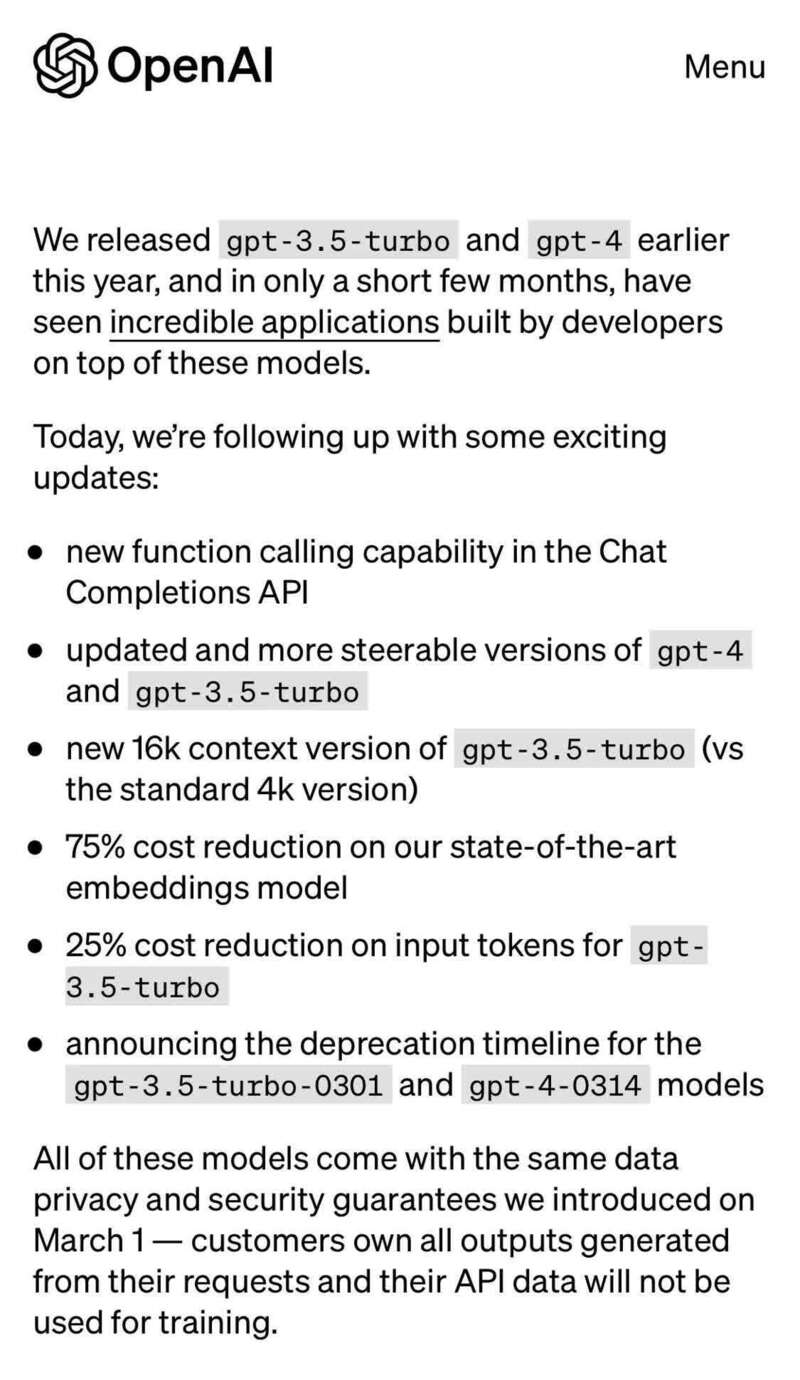

在今天凌晨,OpenAI 突然发布了一个 ChatGPT 的大更新。主要更新内容有:

1️⃣ 在 Chat Completions API 新增函数调用(Function call)功能

2️⃣ 改进了 GPT-4 和 GPT-3.5-turbo 版本

3️⃣ 更新了gpt-3.5-turbo的 16k 上下文版本

4️⃣ 嵌入式模型降低了 75% 的成本

5️⃣ gpt-3.5-turbo 的输入 tokens 成本减少了 25%

6️⃣ 宣布了 gpt-3.5-turbo-0301 和 gpt-4-0314 模型的弃用时间表

OpenAI 也宣布,未来几周内邀请更多人试用 GPT-4,直到完全删除候补名单。

🤔 什么是函数调用?

开发者现在可以向 GPT 模型描述函数,并让模型智能地选择输出一个包含参数的 JSON 对象来调用这些函数调用函数。

简单来说,GPT 能够知道何时要需要用外部工具来解决问题,不再需要开发者为它描述复杂的 Prompt,进一步降低了出错的可能性。

💡举个例子:当你像 ChatGPT 提问「波士顿的天气怎么样?」时,你的问题会被模型解读为调用第三方天气 API,这时候它就会去检索相关的数据,输出准确的回答。【图三】

OpenAI 相当于提供了一个规范的接口调用方式,这将会给基于 GPT 开发应用的开发者们更高的灵活性。

🆕 新模型:

OpenAI 这次一同发布了 gpt-4-0613 和 gpt-3.5-turbo-0613 改进模型,均支持函数调用功能。

OpenAI 还发布了 gpt-3.5-turbo-16k 模型,支持 16000 tokens 的上下文长度,比目前的 gpt-3.5-turbo 要大 4 倍。

ChatGPT 无法输入长文本一直是一个饱受诟病的问题,如今使用 gpt-3.5-turbo-16k 模型,你可以输入长达 20 页的文本,把长文档、论文直接丢给 ChatGPT 读。

gpt-3.5-turbo-16k 是加量不加价,虽然文本量大了 4 倍,但价格只是 gpt-3.5-turbo 2 倍。

OpenAI 还宣布了他们会进一步降低模型运行的成本,以 gpt-3.5-turbo 为例,它的输入 tokens 成本降低了 25%,相当于每美元大约可以处理 700 页文件。